DSAG-Positionspapier: Green (SAP) IT

Stand März 2024

Inhaltsverzeichnis

Positionspapier Green (SAP) IT

Ausgangssituation

Green IT – der neue Fokus

Cloud ist nicht gleich Green IT – ganz im Gegenteil!

Übergreifende Frameworks und Initiativen formieren sich

Forderungen

Positionspapier Green (SAP) IT

Nachhaltigkeit, Digitalisierung und Künstliche Intelligenz bestimmen die aktuellen Konzepte der Strategieberatungen und die Agenda der großen Softwarehersteller – und im Rahmen dieser grundsätzlichen Positionierungen rühmen sich die Betreiber der großen Rechenzentren und auch SAP als Vorreiter im Bereich Nachhaltigkeit.

Doch wie ist es tatsächlich um die Ausgangssituation bestellt und wie sind die aktuellen Public-Cloud-Strategien und das Aufspringen auf den KI-Hype der Softwarehersteller aus diesem Blickwinkel zu bewerten? Der Gegensatz zu den vielen Buzzwords und der zahlreichen Unternehmen, die sich mit dem Thema Nachhaltigkeit schmücken und nicht müde werden, ihre eigene Relevanz zu betonen, sowie dem Vorwurf des „Greenwashings“ wird zunehmend deutlicher.

Aus Sicht der IT bringt der Weg zu einer grünen Informationstechnologie jenseits des Unternehmensimages klare Vorteile. Es bedarf dafür aber eines ganzheitlichen Konzepts, das Umweltverträglichkeit und Ressourcenschonung in den Vordergrund stellt. Denn Unternehmen und die Umwelt profitieren von Green IT gleich auf mehreren Ebenen: ökologisch, ökonomisch und sozial.

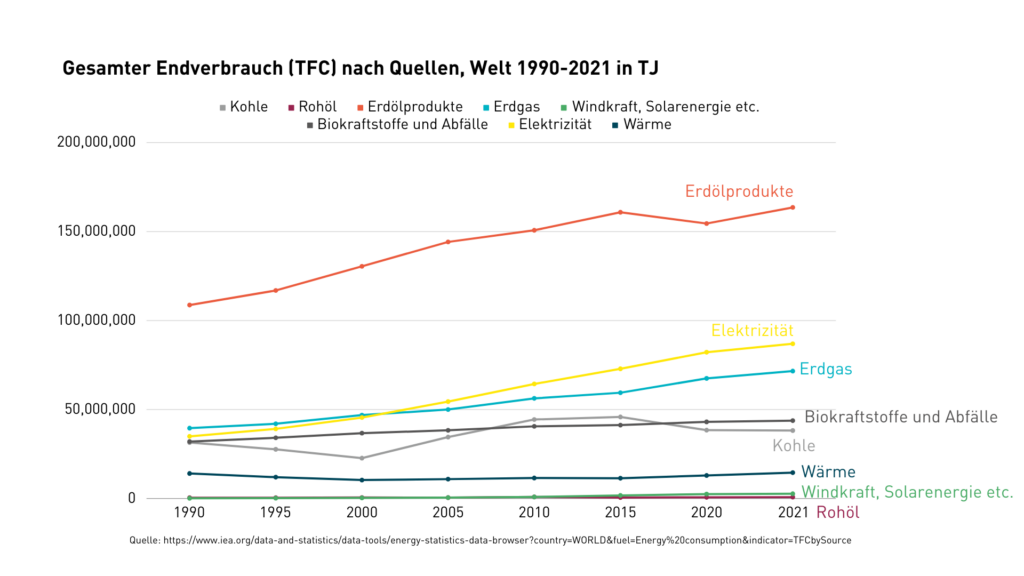

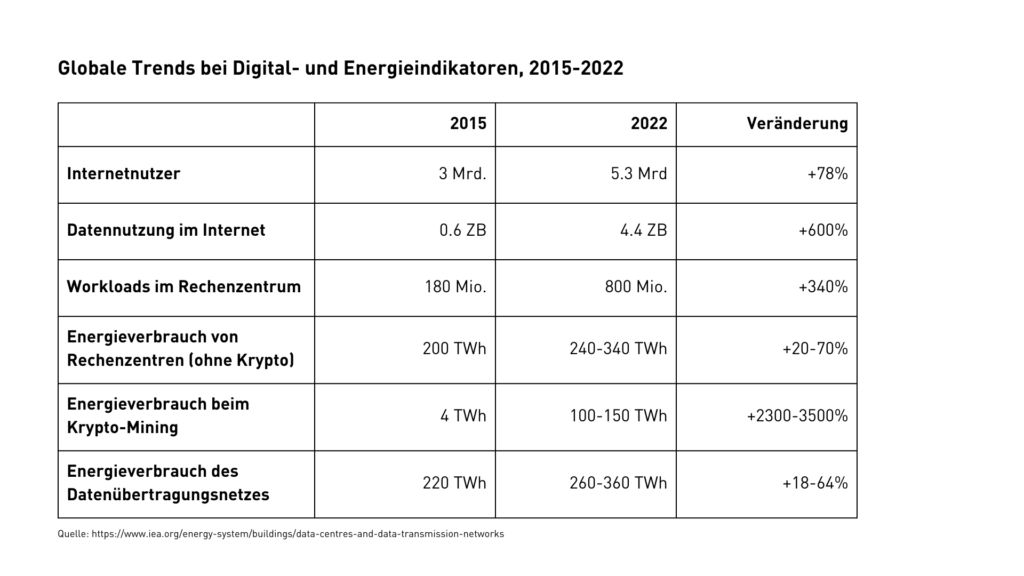

Ausgangssituation

Komplexe IT-Architekturen sind aus unserem Alltag nicht mehr wegzudenken: Rasant steigende Datenmengen werden mit immer leistungsstärkerer Technik verarbeitet und in immer kürzerer Zeit durch die Datenleitungen hin- und hergeschoben. Die Corona-Pandemie hat diese Digitalisierung nochmals beschleunigt, aber auch Schwachstellen offengelegt wie z. B. die vervielfachten Datenübertragungen und -speicherungen. Zusätzliche Geschäftsmodelle wie Cloud Computing oder Streaming verstärken diesen Trend erheblich – und verbrauchen erhebliche Energie und Ressourcen. So ist der weltweite IT-getriebene Energiebedarf laut einer Studie des französischen Think Tanks „The Shift Project“ um jährlich neun Prozent gestiegen – Schätzungen von IT-Experten zufolge, verursacht die IT weltweit ca. drei Prozent der CO2-Emissionen. Ihr Anteil am Gesamtausstoß könnte der Europäischen Umweltagentur EEA zufolge in den nächsten Jahren sogar über acht Prozent betragen.

Anteil des Internets am Energiebedarf

Eine weitere Einordnung liefert der Blick auf die Grundlage des Cloud-Computings und der fortschreitenden Digitalisierung – also auf den Energiekonsum des Internets allgemein. Mit dem Ausbau und der Verbreitung des Internets ist auch dieser Sektor in erheblichem Maße an dem stetig steigenden Energiebedarf beteiligt. Der Anteil am Energiekonsum des Internets beläuft sich bereits auf über zehn Prozent. Je nach Schätzung bleibt dieser Anteil in optimistischeren Szenarien relativ stabil, Prognosen sagen einen Anstieg auf etwa 20 Prozent in diesem Jahrzehnt voraus. Somit wird die Informations- und Kommunikationstechnik vermutlich bereits 2025 mehr CO2-Emissionen erzeugen als jeder Staat der Erde, abgesehen von China, Indien und den USA.

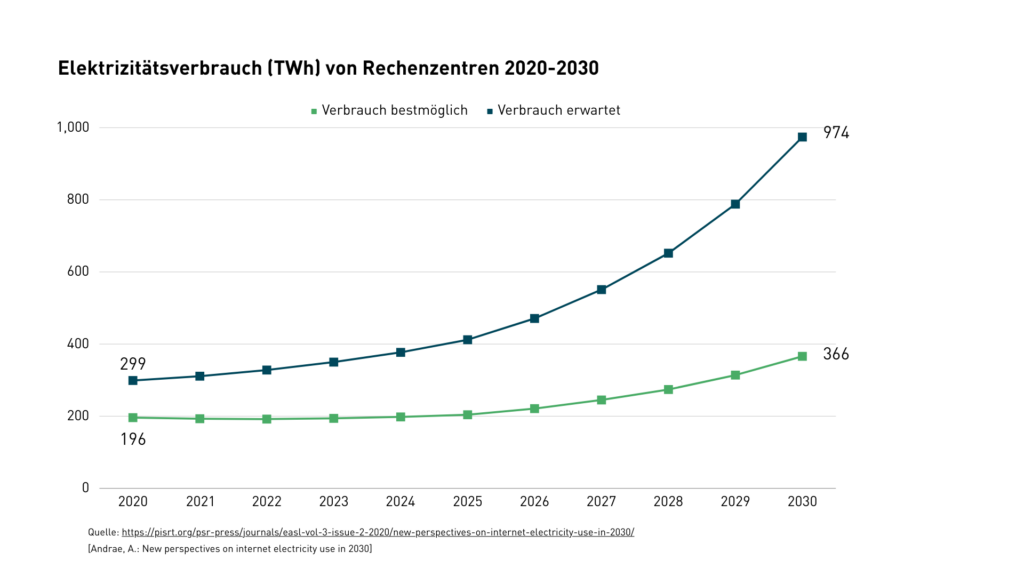

Wesentlicher Verursacher dieser Entwicklung sind die massiven Rechenzentren, die zum Betrieb und zur Vernetzung dieser IT-Landschaften und Cloud-Services zum Einsatz kommen.

Durch das massive Wachstum von Cloud-Rechenzentren und das Wachstum der energiehungrigen Blockchain-Technologie lässt sich das weitere Wachstum als noch exponenzieller vermuten – wird es doch durch die Entwicklung der LLM-Modelle rund um den Hype um Generative KI-Modelle noch weiter befeuert.

Denn die Energie wird nicht nur durch den dauerhaften Betrieb der Rechenzentren benötigt, sondern insbesondere auch für deren Kühlung. Komplexe Kühlsysteme machen mittlerweile etwa 40 Prozent des Energieverbrauchs der Rechenzentren aus.

KI braucht leistungsstarke Prozessoren

Doch eines wird dabei noch ausgeblendet: der unglaubliche Energieverbrauch der neuen Generative-AI-Plattformen und KI-Chatbots wie ChatGPT oder Bard. Denn wie schon das Kryptowährungs-Mining ist auch die KI-Branche auf leistungsstarke Prozessoren angewiesen, um ihre immensen Datenmengen zu verarbeiten. ChatGPT wird von riesigen Rechenzentren betrieben, die Zehntausende dieser energiezehrenden Computerchips verwenden. Schätzungen zufolge gibt allein OpenAI um seinen Chatbot-Dienst mehr als 100 Millionen Benutzer:innen weltweit bereitzustellen, Rechenkosten von schätzungsweise 700.000 US-Dollar pro Tag aus. Wie groß die Auswirkungen auf die Umwelt sind, ist schwer zu berechnen, da die großen Konzerne nicht offenlegen, wie viel Kohlenstoff ihre Modelle ausstoßen. Forscher schätzen, dass das Training von GPT-3 1.287 Megawattstunden Strom und 10.000 Computerchips erfordert hat. Die 550 Tonnen Kohlendioxid, die dabei entstanden, entsprechen 33 Flügen von Australien nach Großbritannien.[1]

In den vorbenannten Verbrauchszahlen spiegeln sich zudem nur der Stromverbrauch von Servern und Infrastrukturen sowie deren Kühlung wider – die Herstellung der Server-Computer, der Netzwerkkomponenten sowie der Transport der Daten fließen nicht in die Rechnung ein.

Dabei spielt das eine wichtige Rolle – am Beispiel der Stadt Frankfurt, der größten nationalen Ballung von Rechenzentren – wird dies besonders deutlich: Die dortigen Rechenzentren machen zusammen bereits ein Viertel des Gesamtstromverbrauchs der Stadt mit ihren gut 750 000 Einwohnern aus.

Green IT – der neue Fokus

Nachdem die Cloud über mehr als eine Dekade die Diskussion um die Zukunft der IT geprägt hat, ist diese Aufregung merklich zurückgegangen – vor allem wohl der Tatsache geschuldet, dass deren Nutzung in den meisten Organisationen zur Selbstverständlichkeit geworden ist. Das bedeutet nicht, dass sich in diesem Umfeld nichts tun würde und „Public-Cloud-only“ das allgegenwärtige Selbstverständnis geworden ist – vielmehr haben sich die Perspektiven verschoben. Es geht nicht mehr so sehr um das „Ob“, sondern um das „Wie“. Die Cloud hat viele Facetten und jedes Unternehmen und jede IT-Unternehmensarchitektur ist spezifisch und damit anders gestrickt.

Im Fokus stehen derzeit die Fragen, wie sich die Cloud-Transformationen beschleunigen lassen – und vor allem, wie die Leistungen unterschiedlicher Cloud-Anbieter optimal einsetzbar sind – und diese Fähigkeiten in Multi-Cloud-Szenarien effizient und übergreifend genutzt werden können. Denn vielfach sind die Cloud-Anbieter nur auf ihr eigenes Produkt- und Lösungsportfolio fokussiert – und schaffen damit in heterogenen IT-Landschaften zusätzliche Sollbruchstellen wie bspw. SAP mit „RISE with SAP“.

Denn die Public-Cloud ist heute nicht die einzige Antwort auf die Herausforderungen der IT. Vielmehr streben die Anwendungsunternehmen klar in Richtung Private-Cloud. So stellen sich vielfach die Szenarien aus der Public Cloud als nicht so preisgünstig skalierbar dar, wie ursprünglich erwartet – zumal die notwendigen Server für den Aufbau einer Private-Cloud durchaus auch von anderen, spezialisierten Dienstleistern eingekauft werden können.

Neue Problemstellungen aufgreifen

Auch wenn es eine der wesentlichen Anforderungen an die IT ist, das eigene Unternehmen dazu zu ertüchtigen, auf neue Anforderungen reagieren zu können – gilt es auch für die IT, neue Problemstellungen aufzugreifen und in der Praxis umzusetzen.

Klassische Fragen der Datensicherheit, -integrität und -haltung sowie alle Fragen des IT-Betriebs sowie einer Beschleunigung der Entwicklungsprozesse und Reduktion der Auslieferungszeiten sind hierbei schon seit Jahren auf dem Radar.

Zunehmen wird auch die Frage nach dem Energieverbrauch. Derzeit zielen die Bemühungen der IT-Branche darauf ab, verstärkt auf Ökostrom als Energiequelle zu setzen und Rechenzentren energieeffizienter zu machen. Denn allein der durch Rechenzentren verursachte Stromverbrauch wird laut Hochrechnungen von IT-Experten von 2015 bis 2025 um mehr als 60 Prozent steigen.

Künftig wird die Frage der Nachhaltigkeit einen erheblichen Einfluss auf Businessmodelle, Produkte und Lieferketten haben. Hersteller, Betreiber und Nutzer sind hier gemeinsam in der Verantwortung – und zwar nicht nur mit dem bisherigen Produkt- und Kundenfokus, sondern auch im Hinblick auf den eigenen Energieverbrauch – nicht zuletzt durch die massiv fortschreitende Digitalisierung. Damit auch für einen noch eher gering ausgeleuchteten Winkel der Unternehmen: den Energieverbrauch der genutzten IT-Infrastrukturen – hier sind besonders fünf Kernbereiche zu nennen: Die Nutzung erneuerbarer Energien, der Wasserverbrauch, die Wärmerückgewinnung, die Ressourcenschonung und die Energieeffizienz.

Energieeffiziente Rechenzentren fördern

Insbesondere die Energieeffizienz als direkteste betriebswirtschaftliche Komponente der Energieeinsparung wird bisher eher nachrangig behandelt; bei dem derzeitigen Preisniveau werden Unternehmen aber zunehmend nach Möglichkeiten suchen, die Energiekosten zu senken. Aber auch der politische Wille wird aktuell klar bekundet – so soll der Anstieg des Stromverbrauchs für Cloud-Dienste und Rechenzentren nach dem Willen der EU-Kommission[2] möglichst begrenzt werden. Ziel der EU ist es, geeignete Infrastrukturen zu entwickeln, um umweltfreundliche, effiziente Cloud-Dienste und energieeffiziente Rechenzentren zu fördern – mit besonderem Fokus auf effizientere Kühlsysteme, die Wiederverwendung von Wärme, den Einsatz erneuerbarer Energien zur Versorgung von Rechenzentren und die Verlegung in kältere Regionen. Wie weit fortgeschritten die Möglichkeiten sind, Energie einzusparen oder zumindest sinnvoll zu nutzen, zeigt das Thema Liquid-Cooling. Mit dieser Flüssigkeitskühlung ist es schon heute möglich, einen Großteil des Wärmestroms abzuführen und somit einen Großteil der mechanischen Kühlung zu ersetzen sowie zusätzlich eine Sekundärnutzung der entstandenen Wärme zu ermöglichen.

Cloud ist nicht gleich Green IT – ganz im Gegenteil!

Vielfach ist zu lesen, dass Cloud Computing zur Verbesserung des sogenannten ökologischen Fußabdrucks beiträgt. Dies ist zwar grundsätzlich richtig, ergibt sich hieraus z. B. eine bessere Auslastungssteuerung, die in Cloud-Rechenzentren aufgrund der Nutzung von Skaleneffekten erzielt werden kann. Hinzu kommt die häufig deutlich bessere Hardware-Ausstattung in modernen Cloud-Rechenzentren, die auch in kürzeren Zyklen durch neue energiesparendere Systeme abgelöst wird. Zudem lassen sich solche Rechenzentren von vornherein an Standorten betreiben, die weniger Kühlung erfordern, als es dem einzelnen Nutzer an seinem lokalen Standort möglich wäre.

Dieser Effizienzgewinn wirkt sich korrespondierend auf den Energiekonsum aus. Eine gut ausgelastete Cloud-Computing-Infrastruktur, die von vielen verschiedenen Personen gleichzeitig in Anspruch genommen wird, kann durchaus weniger Energie benötigen als entsprechend stärker ausgerüstete, voneinander unabhängige Server und Endgeräte. Um den tatsächlichen Unterschied beider Optionen zu vergleichen, ist allerdings zu berücksichtigen, dass nicht unerhebliche Datenmengen zwischen Endgeräten, lokalen Systemen und den Cloud-Plattformen transferiert werden müssen. Wie bereits zuvor beschrieben, kann der Anteil der Internetkonnektivität am Gesamtenergieverbrauch erheblich sein – je nach Art des Cloud-Services. Bei der Speicherung von Daten in der Cloud ist beispielsweise zum einen die Menge und zum anderen die Anzahl der Zugriffe entscheidend. Hierbei gilt, je mehr und je öfter Daten zwischen externem Speicher und dem Endgerät transferiert werden, desto weniger effizient ist die Cloud, bis zu dem Punkt, an dem eine lokale Speicherung um ein Vielfaches weniger Energie verbrauchen würde.

Energie wird verschwendet

Die ökonomische und ökologische Effizienz von Cloud-Computing ist also untrennbar mit der Art und Häufigkeit der Nutzung verbunden. In diesem Zusammenhang tritt zudem das Problem des sogenannten „Cloud Waste“ auf, also der suboptimalen Nutzung von Ressourcen durch eine überproportionierte Cloud-Infrastruktur. Immer dann, wenn Rechenleistung der Cloud-Infrastruktur nicht oder nur zu Teilen genutzt wird (beispielsweise außerhalb der Hauptverkehrszeiten), wird Energie für die Grundversorgung der Hardware verschwendet. Laut Schätzung betrug der Cloud Waste im Jahr 2019 durch eine überproportionierte Cloud-Infrastruktur und dem Leerlauf der Hardware zwischen 30 und 40 Prozent. Überdies wird angenommen, dass im Jahr 2022 täglich weltweit mehr als 333 Milliarden E-Mails versendet bzw. empfangen wurden. Allein in Deutschland verursachten die Emissionen durch die Herstellung und Nutzung digitaler Geräte und Dienstleistungen wie Computer und Smartphones sowie die mit diesen Geräten verursachten Datenübertragungen circa 49,5 Millionen Tonnen CO2eq. Diese Menge entspricht knapp 7 Prozent der Gesamtemissionen in Deutschland im Jahr 2022.[3] [4]

Obwohl also ein zumindest ein theoretisches Potenzial für die effiziente Energieverwendung in der Nutzung von Cloud-Computing liegt, scheint Verschwendung aktuell eher die Regel als die Ausnahme zu sein. Davon abgesehen, sprechen zwei grundsätzliche Konzepte der IT gegen die Idee, dass Cloud-Computing allein zu einem ressourcenschonenderen Umgang mit Rechenleistung führt.

Energieeffizienz wird durch Digitalisierung aufgewogen

Folgt man Jevons Paradoxon[5], so wird die stetig steigende Effizienz von Cloud-Computing nicht dazu führen, dass dieser Industriesektor weniger Energie verbraucht, sondern vielmehr, dass jegliche Energieeffizienz durch die fortschreitende Digitalisierung sowie dem Einsatz von zusätzlichem Cloud-Lösungen aufgewogen wird. Gleichzeitig ist zu befürchten, dass die Anforderungen an (Cloud-)Computing auch in der Zukunft so rasant steigen werden, dass Serverhardware ständig ausgetauscht und durch einerseits effizientere, aber gleichzeitig leistungsstärkere Komponenten ersetzt werden muss. Dies führt neben steigendem Energiekonsum auch zu einem ständigen Austausch von Serverhardware, in der seltene und durch die Art des Minenbaus ökologisch bedenkliche Metalle verwendet werden.

Doch die Millionen Server benötigen nicht nur Strom für den Betrieb und für die Kühlung, deren Leistungen mit gigantischen Ressourcenverbräuchen verbunden sind. Während der Energieverbrauch dieser Einrichtungen aktuell schon für Aufmerksamkeit und Fragen in den Medien und in der Wissenschaft sorgt, ist die Datenlage beim Wasser ebenso knapp, wie die Ressource selbst.[6]

Das Kühlsystem von Rechenzentren benötigt je nach eingesetzter Technologie Wasser (z. B. wassergekühlte Racks; Klimaanlage mit zentraler Kaltwassererzeugung, kombiniertes Umluft- und Kaltwassersystem, Kühltürme usw.), um die entstehende Wärme der Anlagen durch die Verdunstungskälte des Wassers effizient abzuführen. Im Sommer bzw. in heißen Regionen wird dafür verständlicherweise mehr Wasser verbraucht. Viele Rechenzentrumsbetreiber zieht es in wasserarme Regionen im Westen der USA, aber auch nahe der Großstädte Europas, wie Amsterdam oder Frankfurt – überwiegend wegen der Verfügbarkeit von Solar- und Windenergie oder nahegelegenen, großen Internetknotenpunkten. Aber genau dort herrscht Wasserknappheit, die ein Problem darstellt, wenn auf natürliche Ressourcen zurückgegriffen wird.

Mangel an betrieblichen Verbrauchsdaten

Angesichts der Nachhaltigkeitsanforderungen von Stakeholdern und Gesetzen ist es erforderlich, dass die Rechenzentrumsbetreiber und Cloud-Anbieter offener mit dem Thema umgehen. Die Betreiber werden nach heutigem Stand vor allem nach ihrer PUE (Power Usage Effectiveness) und der Reduktion des Stromverbrauchs bewertet. Die korrespondierende Kennzahl WUE (Water Usage Effectiveness) gibt nur Auskunft darüber, wieviel Wasser in dem Prozess verloren geht, und nicht den tatsächlichen Verbrauch. Es wird also nur die Wassermenge gemessen, die verdunstet und nicht die Menge, die von Rechenzentren aufgenommen und dann wieder abgeleitet wird. Das ist aber insbesondere für die Wasserstressregionen und die Nutzung von Grundwasserressourcen eine elementare Größe. Bei den Betreibern der Rechenzentren mangelt es nicht an Berichten und Projekten, seltener fündig wird man allerdings bei den betrieblichen Verbrauchsdaten.

Während der Wasserverbrauch von Rechenzentren lange ein Tabuthema war, nimmt die Öffentlichkeit zunehmen Kenntnis davon und es gibt erste spürbare Reaktionen:

- In den Niederlanden hat die Regierung im Februar 2022 ein elfmonatiges Moratorium für den Bau von Großrechenzentren ausgesprochen und damit neue Vorhaben gestoppt – wobei es vorrangig um Energie geht. Währenddessen wird Microsoft vorgeworfen, mit 84.000 Kubikmetern Wasser das Vierfache der genehmigten Wassermenge in 2021 genutzt zu haben. Der Verband der Datencenter-Betreiber widerspricht diesen Zahlen und verweist auf den vergleichsweise geringen Wasserbedarf.[7][8]

- Dasselbe gilt für Irland: Hier fangen bereits einige Politiker an, sich aus Angst vor einer Wasserknappheit zu organisieren. Im August vergangenen Jahres wurde ebenfalls ein Moratorium für den Bau neuer Rechenzentren ausgesprochen. Die zu dem Zeitpunkt bestehenden 30 Großrechenzentren in Irland sollten massiven Zuwachs bekommen.[9]

- In Frankreich, Luxemburg, aber auch in Deutschland stoßen die Pläne für Mega-Rechenzentren auf immer mehr Fragen und Kritik. Es ist nicht überraschend, dass diese zunehmend ablehnende Haltung der Öffentlichkeit gegenüber Rechenzentren im Zusammenhang steht mit deren Wasserbedarf, mit sinkenden Wasservorräten und sich abzeichnenden Nutzungskonkurrenzen.[10]

Keine Daten über den Wasserverbrauch

Der Wasserbedarf von Daten wird weltweit wachsen. Nach Angaben der Synergy Research Group gab es bis Ende 2020 weltweit etwa 600 „Hyperscale Data Center“ (Großrechenzentren). Ihre Zahl hatte sich seit dem Jahr 2015 verdoppelt. Fast 40 Prozent dieser Großrechenzentren befinden sich allein in den USA, mehr als die Hälfte davon entfallen auf Amazon, Google und Microsoft. Diese Rechenzentren werden nicht selten in Regionen errichtet, in denen Wasser ein knappes und mithin umkämpftes Gut ist. Es bedarf somit einer hohen Transparenz, wie viel Wasser für die Rechenzentren tatsächlich benötigt wird. Aber genau hier gibt es ein Problem: Ausgerechnet jene Unternehmen, deren Kerngeschäft Daten sind, haben keine Daten über ihren Wasserverbrauch oder machen ihn zumindest nicht öffentlich. Die erforderliche Transparenz ist nur bei weniger als einem Drittel der Rechenzentrumsbetreiber, die den Wasserverbrauch messen, zu erkennen. Ein im November 2021 veröffentlichtes Papier untersucht den Wasserverbrauch von Rechenzentren und die Messung ihrer Verbräuche. Im Ergebnis heben die Autoren den Mangel an verfügbaren Daten zur Bewertung der Wassereffizienz hervor und diskutieren, wie die Branche versucht, den zukünftigen Verbrauch zu reduzieren.

Über den Ressourcenverbrauch Bericht erstatten

Es ist erstaunlich, dass dort wo mit Daten Geld verdient wir, diese nicht verfügbar sind, wenn es um den Wasserverbrauch geht. Es gilt also, die heute zu günstigsten Konditionen gesicherten Trinkwasserzugriffe der Großkonzerne durch Recycling von nicht verdunstetem Wasser oder Wasser aus dem Kläranlagenabfluss zu ersetzen. Bessere Energienutzung, effizientere Kühlsysteme und erhöhte Arbeitslasten pro bereitgestelltem Server können zudem die Wassereffizienz größerer Rechenzentren weiter erhöhen.

Im Zuge der steigenden Nachhaltigkeitsanforderungen werden auch die Betreiber von Rechenzentren über den Ressourcenverbrauch Bericht erstatten müssen. Insbesondere werden sie aufzeigen müssen, wie sie ihren Wassereinsatz reduzieren.

Dafür gibt es zahlreiche Stellhebel. Der eine setzt beim virtuellen Wasserbedarf an. Die Umstellung auf die Nutzung regenerativer Energien reduziert neben dem CO2-Fussabdruck auch den H2O-Fussabdruck, also die Zurechnung virtuellen Wassers, das bei der Energieerzeugung zum Beispiel für konventionelle Kraftwerke erforderlich ist. Der nächste Spareffekt betrifft die Kühlung der Anlagen. Hier finden sich zahlreiche Beispiele, mit denen der Kühlwasserbedarf reduziert werden kann. Hinzu kommt eine Änderung der Bezugsquellen des Wassers, also Brauchwasser oder Meerwasser anstelle von Frischwasserressourcen.

Neuere Rechenzentren setzen bereits auf modulare Combined-Energy-and-Cooling-Cells (CECC)-Konzepte zur Kühlung und erreichen durch diese modernen Kühlsysteme bis zu 70 Prozent weniger Energieverbrauch bei Kühlung und Betrieb.

Erste Erfolge stellen sich ein

Nach einer Studie des Centre for Environmental Policy am Imperial College London aus dem Jahre 2021 zeigen sich erste Erfolge bei der Umstellung auf erneuerbare Energien. Zwischen 2010 und 2018 hat sich demnach die Zahl der Server versechsfacht, der Datenfluss verzehnfacht und die Speicherkapazität um das 25-fache erhöht, dabei ist der Energieverbrauch aber nur um 6 Prozent gestiegen. Erste Rechenzentrumsbetreiber beginnen, wiederaufbereitetes oder recyceltes Wasser anstelle von Trinkwasser einzusetzen. Dieses Brauchwasser bezieht dann z. B. Amazon Web Services (AWS) von lokalen Wasserunternehmen, die das auf unterhalb der Trinkwasserstandards umgewandelte Abwasser aus Haushalten oder der Industrie liefern.

Auch werden erste adiabatische Kühlungssysteme eingesetzt: Dabei wird bei Temperaturen unter 30 Grad Celsius kühlere Außenluft anstelle von Wasser zur Kühlung verwendet. Liegen die Temperaturen über 30 Grad, wird ein Verdunstungskühlsystem eingesetzt. So werde weniger Strom und bis zu 90 Prozent weniger Wasser als bei konventionellen wasserbasierten Kühlsystemen benötigt. In Kombination mit dem Einsatz von Solarenergie kann der virtuelle Wasserverbrauch deutlich reduziert werden.

Insgesamt mutet es jedoch erschreckend an, dass nur jeder zweite Betreiber von Rechenzentren in einer Befragung des Uptime Instituts angab[11], seinen Wasserverbrauch zu erfassen. Nur jeder zehnte Betreiber hat dabei die Lieferkette, also auch den energieverursachten Wasserverbrauch im Blick. Dies gilt es schnellstmöglich zu ändern, in Richtung klarer, objektiver und einheitlicher Angaben – egal auf welcher Ebene. In Anbetracht der steigenden Anforderungen an die Nachhaltigkeitsberichterstattung in der EU in Folge der Corporate Sustainability Reporting Directive (CSRD)-Richtlinie dürfte diese Daten-Dürre bald ein Ende haben. Investoren und Banken sowie viele andere Stakeholdergruppen werden verstärkt auch von Rechenzentren Angaben fordern, wie sie mit der Ressource Wasser – zumal in Stressgebieten – umgehen. Ungeachtet dessen, müssen wir uns als IT-Verantwortliche fragen, wie wir unsere IT-Infrastrukturen nachhaltiger ausrichten können.

Übergreifende Frameworks und Initiativen formieren sich

Technologie ist der entscheidende Weg zur Nachhaltigkeit von Unternehmen, und IT-Führungskräfte haben die einmalige Gelegenheit, ihre Funktionen, Unternehmen und Branchen für eine nachhaltige Zukunft zu transformieren. Doch gibt es heute ein komplexes Netz teilweise überlappender Nachhaltigkeitsstandards in verschiedenen Reifegraden. In globalen Organisationen kommt meist eine Mischung aus den Global Reporting Initiative (GRI)-, Sustainability Accounting Standars Board (SASB)- und Task Force on Climante-Related Financial Disclosures (TCFD)-Frameworks zur Steuerung der Nachhaltigkeitsberichterstattung zum Einsatz – bis hin zu branchenspezifischen Standards von ISO und anderen Institutionen. Die TCFD-Standards wurden bereits in Neuseeland, der Schweiz und in Hongkong als gesetzliche Anforderungen an die Berichterstattung für Großunternehmen verankert. Der Trend, Nachhaltigkeitsberichterstattung und Finanzen im Rahmen der Unternehmensberichterstattung zu kombinieren, wird zudem durch Organisationen wie der International Financial Reporting Standards (IFRS) Foundation und dem Financial Stability Board (FSB) unterstützt und weiterentwickelt.

Standardisierter Weg für CIOs und CTOs

Doch die heutigen Berichtsrahmen sind nicht granular genug, um Technologiebereiche dabei zu unterstützen, direkte Maßnahmen ergreifen zu können – insbesondere, da sie keine konsistenten Definitionen oder Metriken bereitstellen, die für IT-Funktionen branchenübergreifend nutzbar sind. Auch werden CIOs und andere IT-Führungskräfte allzu oft nicht einbezogen bei der Festlegung der Nachhaltigkeitsziele ihrer Unternehmen – laut eines Berichts von Info-Tech Research aus dem vergangenen Jahr verfügen nur 18% der befragten Unternehmen über nachhaltige IT-Strategien.

Eine gute Orientierung bieten hier z. B. die Anfang 2023 veröffentlichten Standards von SustainableIT.org, die darauf abzielen, CIOs und CTOs einen standardisierten Weg zu bieten, der die Messung, Verfolgung und Berichterstattung von Nachhaltigkeitsaktivitäten unterstützt und in bestehende ESG-Offenlegungsrahmen und -richtlinien integrierbar ist. Im Fokus stehen hier die Umweltstandards für die vier Segmente Energie, Emissionen, Abfall und Beschaffung. Die mittlerweile entwickelten mehr als 200 auf die IT zugeschnittenen ESG-Standards bieten einen branchenübergreifenden, konsistenten Satz von Themen und Kennzahlen zur Messung, Verfolgung und Berichterstattung der ESG-Auswirkungen der Technologie. Die Präsentation rechts stellt IT-spezifische Auswirkungsdaten und -modelle bereit und erläutert die Verwendung der Standards. Diese Kennzahlen sollen nicht nur die Offenlegung unterstützen, sondern auch dabei helfen, Verbesserungspotenziale zu identifizieren und entsprechende Priorisierungen und Zielsetzungen zu unterstützen. Diese SustainableIT-Standards sind mit GRI, SASB und TCFD kompatibel. Die heute schon verfügbaren, mehr als 200 auf die IT zugeschnittenen ESG-Standards bieten einen branchenübergreifenden, konsistenten Satz von Themen und Kennzahlen zur Messung, Verfolgung und Berichterstattung der ESG-Auswirkungen in der Technologie.

Initiative “Klimaneutrale Rechenzentren”

Zeitnah zur Verabschiedung der Klimaziele durch die EU und die Bundesregierung wurde im Jahr 2021 die Initiative „Klimaneutrale Rechenzentren“ gegründet, die auch Teil des “Climate Neutral Data Center Pacts” – einer Initiative zur Förderung umweltfreundlicher Rechenzentren und nachhaltiger Digitalisierung – ist. Aktive Mitglieder dieser Initative erlegen sich selbst höhere Ziele und Messwerte auf, als der Gesetzgeber verlangt. Während andere beim Thema Klimaneutralität noch am Anfang stehen, setzen die zertifizierten Teilnehmenden bereits konkrete Maßnahmen um und erfüllen heute schon die Kriterien des „Climate Neutral Data Centre Pacts“. Die festgelegten Ziele betreffen die folgenden Themenbereiche:

- Nachweis der Energieeffizienz mit messbaren Zielen

- Nutzung von 100 % regenerativer Energie

- Ressourceneffizienter Umgang mit Wasser

- Wiederverwendung und Reparatur von Servern

- Untersuchung von Möglichkeiten zur Wärmerückgewinnung

Forderungen

Die Forderungen an die Rechenzentrumsbetreiber und Hyperscaler lassen sich somit klar definieren:

- Es braucht vollständige Transparenz über den Ressourcenverbrauch der Rechenzentren, eine zeitnahe Realisierung der Umstellung auf echten Ökostrom und die konsequente Nutzung von Brauchwasser anstelle von Trinkwasser. Außerdem sollte der Einsatz energieeffizienter Server und Infrastrukturkomponenten sowie alternativer Kühlmechanismen und -technologien transparent gemacht und für die Kunden damit aktiv wählbar sein.

- Und in Bezug auf die kommerziellen Modelle braucht es eine Abkehr vom heute aktiv vertriebenen und kostengünstigeren Preismodells „Always-On/Reserved Instances“ und einen Ersatz durch echte skalierende Preis- und Betriebsmodelle, damit der Kunde aktiv den Ressourcenverbrauch steuern kann.

Dazu kommen die Forderungen an SAP:

- Die heutigen Cloud-Services und -Plattformen müssen ebenfalls sehr viel flexibler steuerbar gestaltet werden – besonders deutlich wird das am heutigen Always-On-Modus der Services der Hyperscaler-basierten BTP und bei der effizienten Datenverwaltung zwischen den SAP Cloud Services – denn jeder permanent vorgehaltene BTP-Service und jeder internetbasierte Datentransfer verursacht entsprechenden Energiebedarf.

- Es braucht die seit langem von der DSAG geforderte Unterstützung hybrider IT-Architekturen anstelle des rigorosen Ansatzes ‚Public Cloud-only‘. Dementsprechend müssen die SAP-SaaS-Plattformen ebenso getrennte DEV/INT/PRD-Instanzen anbieten, die die Unternehmen dann entsprechend ihrem Bedarf skalieren können – dies würde auch das derzeitige Pricing-Modell (DEV=PRD) marktfähiger gestalten bzw. für die Unternehmen wirtschaftlich machen. Dass ein solcher Ansatz technologisch umsetzbar ist, zeigen verschiedene Lösungen am Markt sowie seit November 2023 die SAP selbst mit der ersten Version der Edge Integration Cell, die ein gezieltes, lokales Deployment anstelle eines permanenten Cloud-Services ermöglicht.

- Analog zu dieser Lösung ist grundsätzlich eine stärkere Containerisierung von SAP-Services notwendig, um Software auf konsistente Weise in verschiedenen Umgebungen zu paketieren und bereitzustellen. Lassen sich doch hiermit nicht nur Herausforderungen wie z. B. Abhängigkeitskonflikte und Plattformdiskrepanzen lösen, indem Anwendungen zusammen mit ihren Abhängigkeiten in leichten, tragbaren Containern gekapselt werden, sondern auch eine Installation an Standorten realisieren, die den energetischen Footprint optimieren und internetbasierten Traffic minimieren.

- Um beim konkreten Ressourcenverbrauch nachhaltig agieren zu können, braucht es allerdings auch entsprechende SAP-Lösungen – daher ist die Aussage von SAP, dass das Green-Ledger nur gegen Aufpreis und ausschließlich für RISE-Premium-Kunden bereitgestellt wird, besonders kritisch zu bewerten – und es stellt sich die Frage, wie ernst es SAP mit der Ankündigung wirklich meint, Unternehmen auf dem Weg zu mehr Nachhaltigkeit zu unterstützen. Durch diese einseitige Preispolitik und die Einstellung der bisherigen Produkte Sustainability Control Tower und Sustainability Footprint Management werden Anwenderunternehmen angehalten, sich nach Alternativlösungen mit langfristigen Einsatzszenarien umzuschauen.

Und schließlich ist auch die Politik gefordert (s. EU-Initiative)

- Es bedarf verbindlicher Transparenzpflichten für Rechenzentrumsbetreiber die konsequent ein Teil der obligatorischen Nachhaltigkeitsberichterstattung sind.

- Es muss eine einheitliche Logik zur Ermittlung des verursachten Datenverkehrs eingesetzter SaaS-Lösungen eingefordert werden, um als Unternehmen den heute intransparenten Ressourcenverbrauch messen und steuern zu können.

Abschließend ist es die Kernaufgabe aller IT-Entscheider und damit der DSAG-Anwendungsunternehmen, bei der Ausschreibung von Rechenzentrumsleistungen/IT-Infrastrukturen und Cloud Services eben diese Transparenz und die Einhaltung bestehender Standards der vorbenannten Initiativen einzufordern und zum obligatorischen Ausschlusskriterium einer Vergabe zu machen (ohne Offenlegung kein Zuschlag). Zudem muss das laufende Monitoring des Ressourcenverbrauchs für die vom Unternehmen genutzten Services/Ressourcen und die aktive Skalierung dieser Dienste (aktives Aktivieren/Herunterfahren) in die Anforderungskataloge mit aufgenommen werden.

Die DSAG hat sich ganz bewusst einer Nachhaltigkeitsinitiative verschrieben, die in den Ressorts Technologie sowie Transformation & Sustainability abgestimmt, gebündelt, und gemeinsam gelebt wird.

[1] https://arxiv.org/ftp/arxiv/papers/2104/2104.10350.pdf, zuletzt abgerufen 21.03.2024 um 09:16 Uhr

[2] https://ec.europa.eu/newsroom/dae/redirection/document/70622, zuletzt abgerufen 21.03.2024 09:21 Uhr

[3] https://www.radicati.com/wp/wp-content/uploads/2020/12/Email-Statistics-Report-2021-2025-Executive-Summary.pdf, zuletzt abgerufen 21.03.2024 09:24 Uhr

[4] https://www.oeko.de/fileadmin/oekodoc/Digitaler-CO2-Fussabdruck.pdf , zuletzt abgerufen 21.03.2024 09:25 Uhr

[5] https://de.wikipedia.org/wiki/Jevons-Paradoxon, zuletzt abgerufen 21.03.2024 um 09:38 Uhr

[6] https://time.com/5814276/google-data-centers-water/, zuletzt abgerufen 22.04.2024 10:22 Uhr

[7] Dutch government halts hyperscale data centers, pending new rules, zuletzt abgerufen 21.03.2024 09:32 Uhr

[8] Datacenter Microsoft Wieringermeer slurpte vorig jaar 84 miljoen liter drinkwater, zuletzt abgerufen 21.03.2024 09:33 Uhr

[9] Amazon’s plans for two Dublin data centres meet with opposition, zuletzt abgerufen 21.03.2024 09:35 Uhr

[10] rbb24: „Google-Ansiedlung in Ostbrandenburg scheitert an Wassermangel“, zuletzt abgerufen 21.03.2024 09:36 Uhr

[11] Ignore Data Center Water Consumption at Your Own Peril, zuletzt abgerufen 21.03.2024 09:40 Uhr